Arten von Prompting

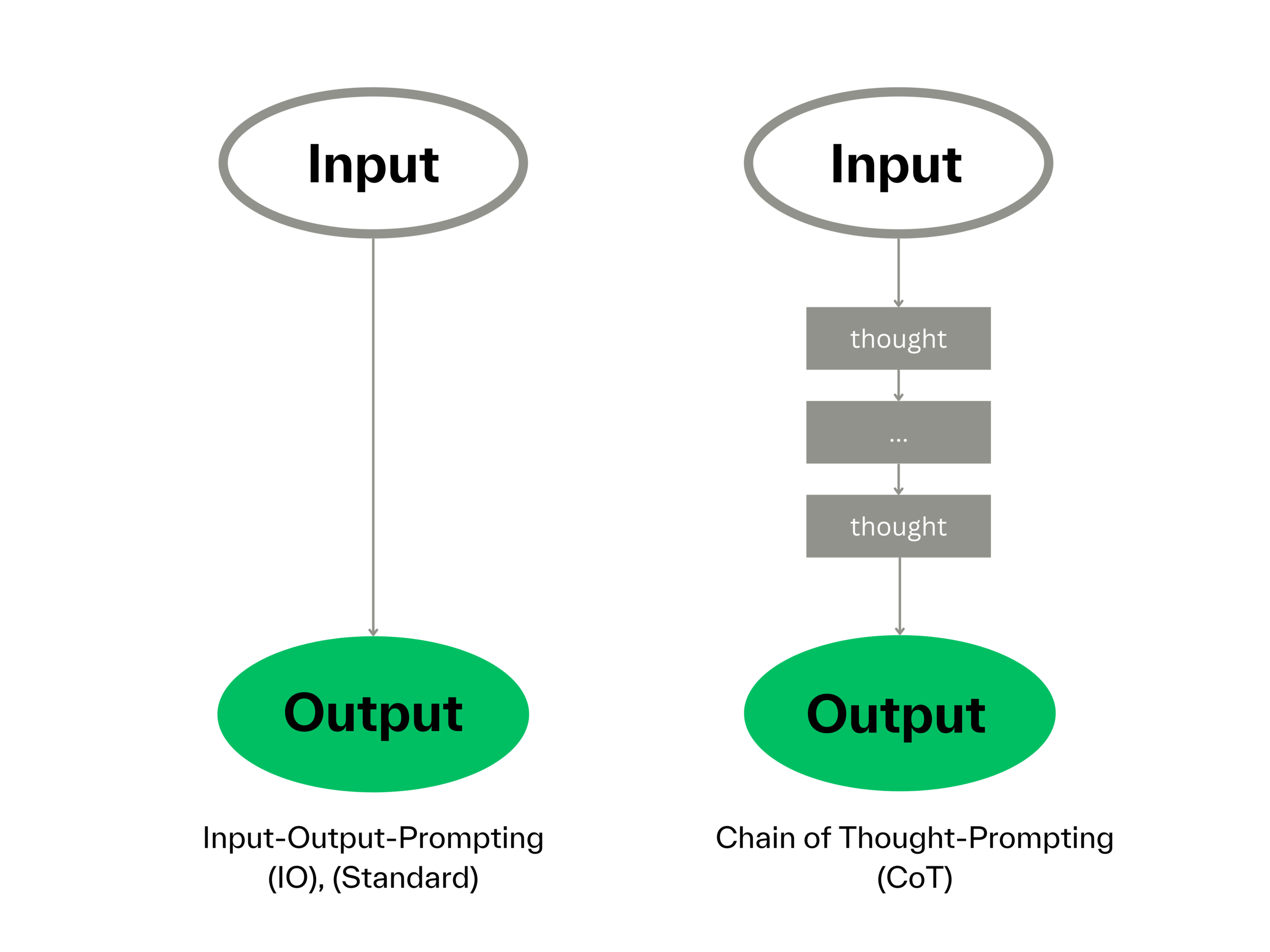

Im Artikel ChatGPT-Promptkompetenz beschreiben wir, dass das zentrale Anliegen des Prompt-Designs bzw. des Prompt-Engineerings darin liegt, eine optimale Eingabe (Input) zu formulieren, die das Sprachmodell befähigt, die gestellte Aufgabe bestmöglich zu bewältigen. Auf dieser Seite beleuchten wir eine spezifische Form, das sogenannte „Chain of Thought”-Prompting, abgekürzt CoT-Prompting.

Chain of Thought-Prompting

Schrittweise Lösung aufzeigen

Beim CoT-Prompting geht es darum, dem Sprachmodell dabei zu helfen, systematisch über eine Aufgabe nachzudenken und eine Lösungsstrategie zu entwickeln. Stellen Sie sich vor, Sie haben eine Reihe von Fragen, die Ihnen helfen, Ihre Gedanken in die richtige Richtung zu lenken. Diese Fragen oder Anregungen sind miteinander verbunden und führen Sie Schritt für Schritt durch den Prozess, um eine Antwort oder Lösung zu finden. Beim CoT-Prompting dient Ihr Input als Leitfaden für die KI, schrittweise eine Lösungsstrategie für die gegebene Aufgabe im Output (Textausgang) zu präsentieren. Dabei setzen Sie eine Reihe miteinander verbundener Fragen, um einen logischen Fluss von Antworten zu fördern.

Wie funktioniert's?

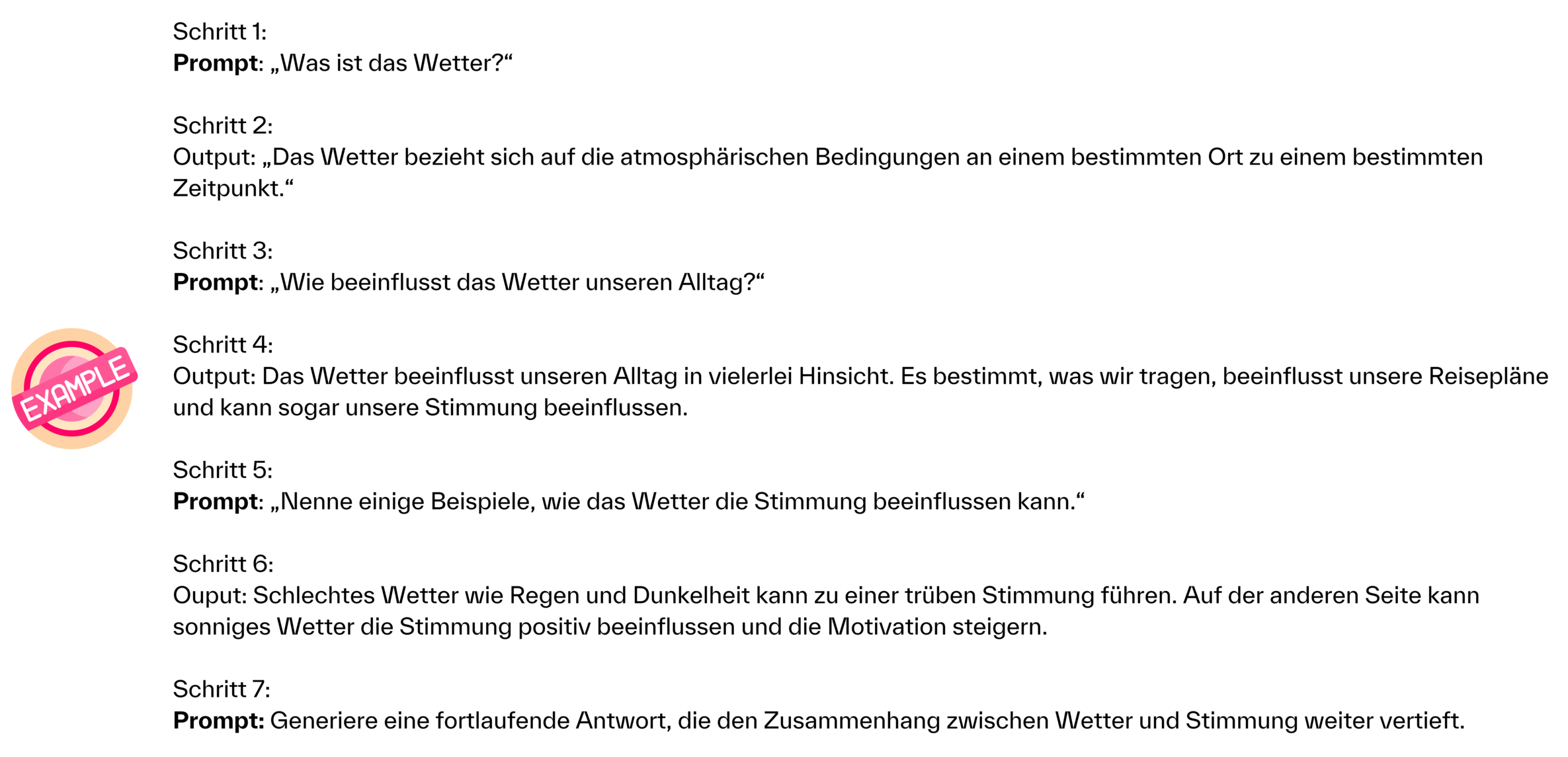

CoT-Prompting kann mit ChatGPT durchgeführt werden, indem aufeinanderfolgende Fragen oder Anweisungen gestellt werden, die auf die vorherigen Antworten aufbauen. Dem Modell werden schrittweise mehr Kontext oder Informationen für eine zusammenhängende Antwort gegeben.

In diesem Beispiel wird mit einer grundlegenden Frage (Schritt 1) begonnen und dann schrittweise auf die vorherige Antwort aufgebaut, indem weiterführende Fragen gestellt werden (Schritte 3 und 5). Auf diese Weise wird das Modell dazu ermutigt, einen fortschreitenden Gedankengang zu entwickeln und den Kontext seiner vorherigen Antworten zu berücksichtigen, um eine zusammenhängende Antwort zu generieren.

Nachweislich bessere Ergebnisse

Das CoT-Prompting gewährt uns damit einen scheinbaren Einblick in die Denkweise der KI, indem sie uns ihre gedanklichen Schritte zur Lösung einer Aufgabe erklärt. Es wird eine vermeintliche Abfolge von Gedanken sichtbar. Allerdings konnten Forscher:innen von Google DeepMind und der Princeton University abgesehen von der Steigerung der Transparenz im Prompting durch Experimente mit verschiedenen Sprachmodellen nachweisen, dass die Ergebnisqualität ab einer bestimmten Größe des Modells durch das CoT-Prompting verbessert wird (Wei & Zhou 2022).

Tree of Thoughts-Prompting

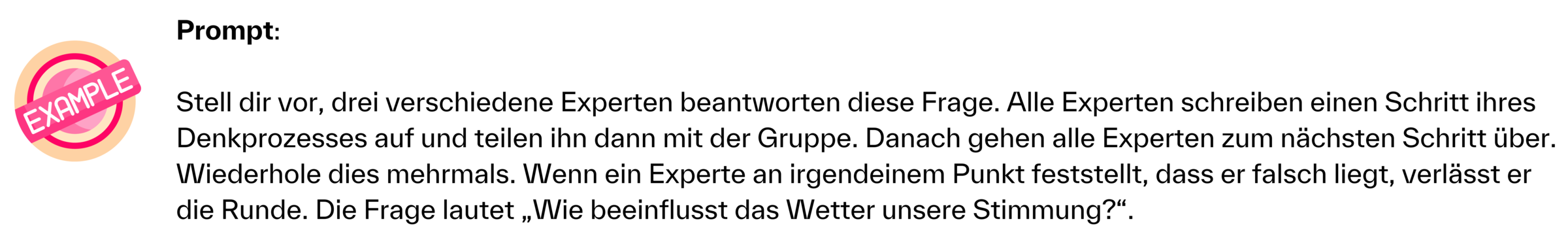

Dem linearen Ansatz des CoT-Promptings steht ein weiteres Framework gegenüber: das Tree of Thoughts-Prompting, kurz ToT-Prompting. Stellen Sie sich vor, drei Expert:innen diskutieren über die beste Vorgehensweise für ein komplexes Problem in ihrer Branche. Jede:r Expert:in bringt verschiedene Ideen und Lösungsansätze ein, verschiedene Möglichkeiten werden erkundet, bewertet und letztendlich die beste Entscheidung für die Lösung getroffen. Genau ein solches Szenario wird beim ToT-Prompting veranlasst.: Beim ToT-Prompting werden mehrere Reihen von Schritten verfolgt und auch ein Bewertungsschema integriert. Jeder Schritt wird sorgfältig überprüft, wodurch eine gründlichere und evaluierende Herangehensweise ermöglicht wird. Während CoT einen geradlinigen Weg vorschlägt, folgt ToT einem Strukturmodell, das einem Baum- und Zweigrahmen ähnelt.

Der ToT- Ansatz ermöglicht es dem Modell, die Zwischengedanken selbst zu bewerten und zu entscheiden, ob es mit diesem Pfad fortsetzen oder einen anderen wählen soll.

ToT ist inspiriert von der Herangehensweise, komplexe Denkaufgaben durch das Prinzip „Trial and Error“ (Versuch und Irrtum) zu lösen. Diese Technik bringt die KI also dazu, verschiedene Ideen zu erkunden und bei Bedarf neu zu bewerten, um die optimale Lösung zu finden.

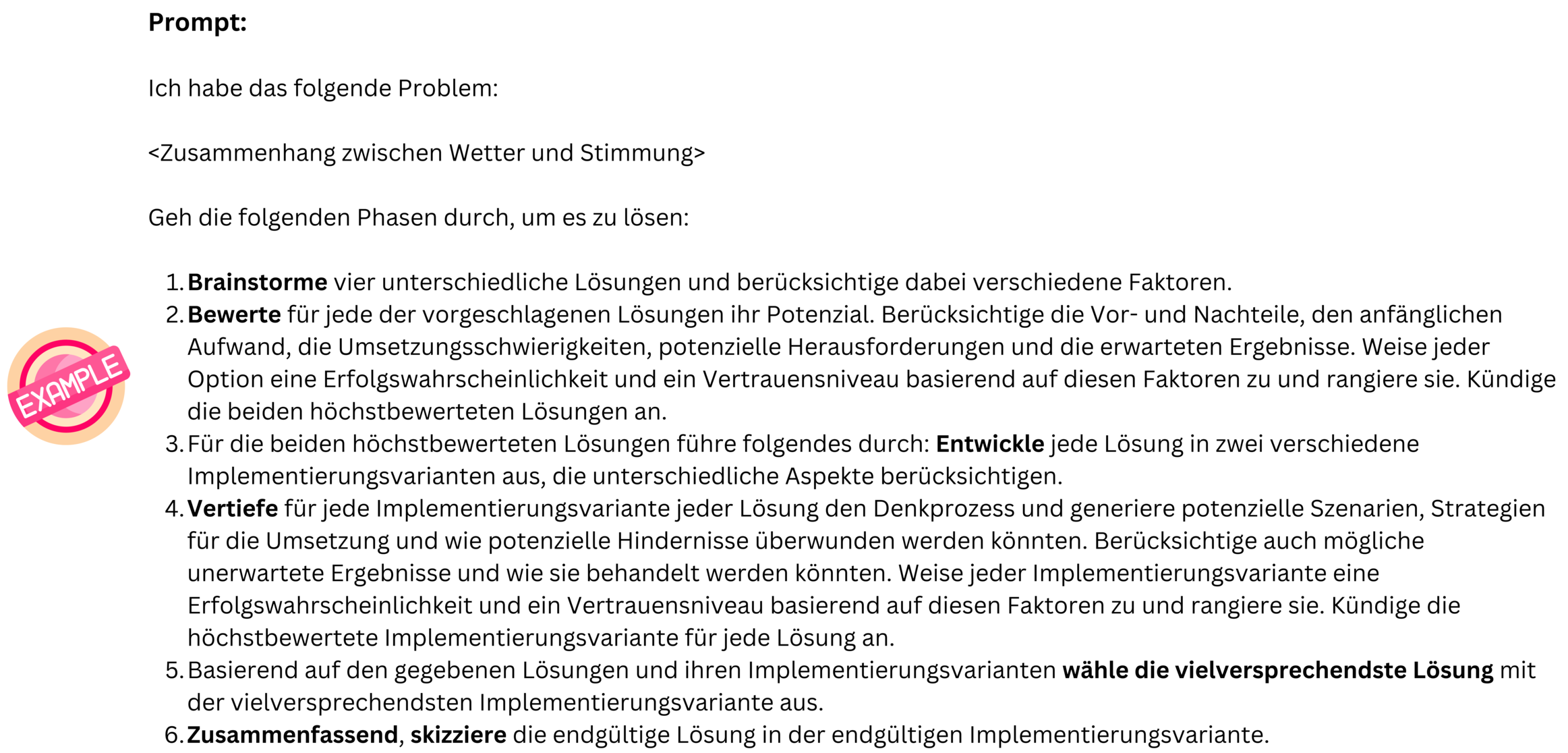

1. Beispiel:

2. Beispiel:

Beispiel ToT-Prompt nach Reddit-Post „My Tree of Thoughts-Prompt“ des User bebosbebos || Klick auf das Bild für Großansicht

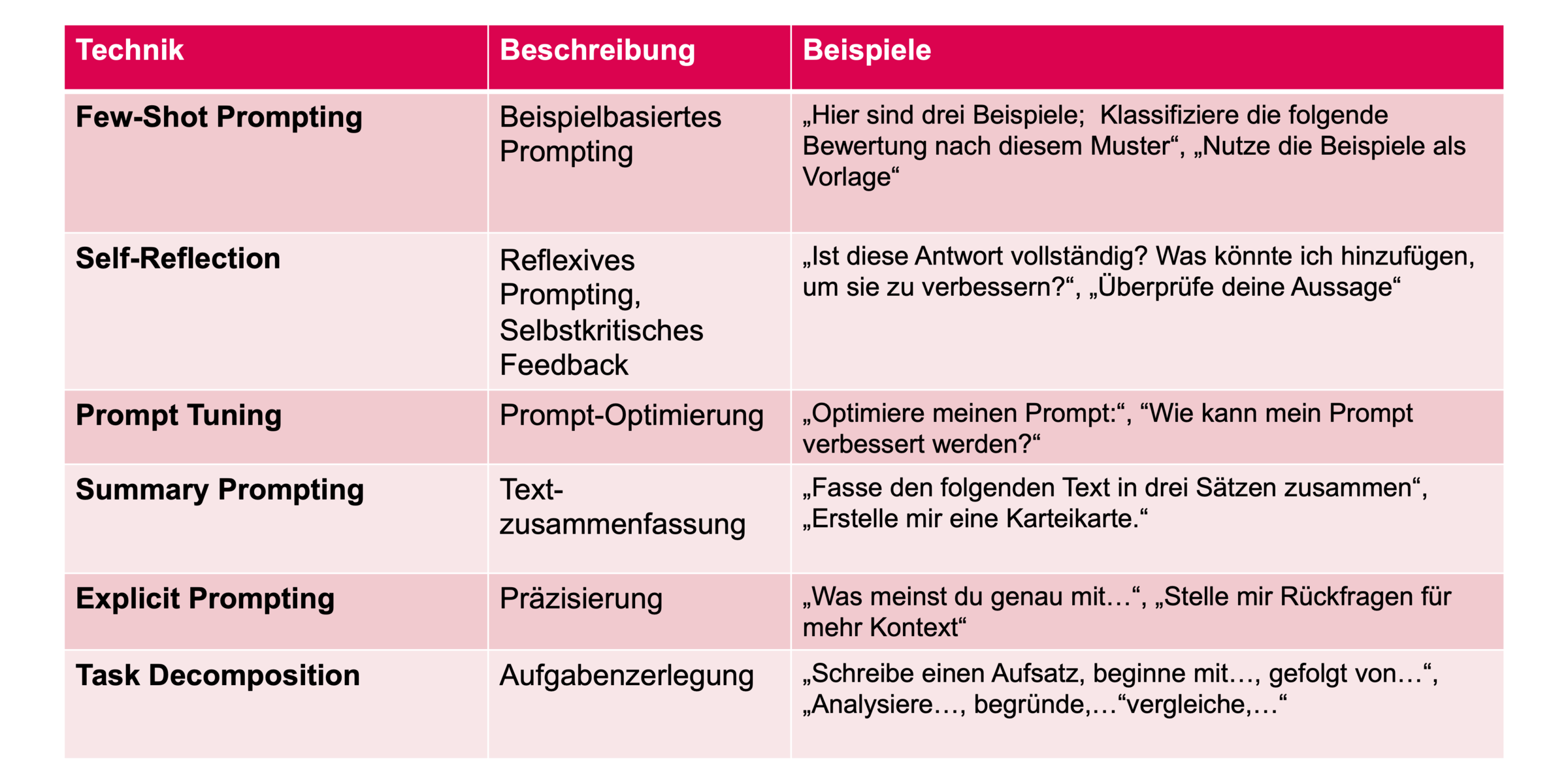

Weitere Promptingtechniken

Ansprechpartnerin | |

Telefon: | +49 821 5586-3023 |